Les intelligences artificielles ont grandement évolué depuis quelques années. Désormais, des chercheurs tentent de démontrer quel modèle d’IA est le plus efficace face à un test de QI.

La montée en puissance de l’IA

Le paysage de l'intelligence artificielle voit l'émergence de Claude 3, la troisième génération du grand modèle de langage (LLM) développé par Anthropic. Publiée récemment, cette IA impressionne les observateurs avec ses performances supérieures à celles des modèles concurrents tels que GPT-4 d'OpenAI et Gemini de Google.

Les résultats de divers benchmarks confirment la domination de Claude 3 dans des domaines clés tels que les connaissances de premier cycle, le raisonnement, et les compétences mathématiques de base. Anthropic propose une gamme variée de modèles de Claude 3, allant du plus grand, Opus, au plus petit, Haiku, chacun optimisé pour différents équilibres entre intelligence, vitesse et coût.

Anthropic positionne Claude 3 comme une avancée significative, surpassant les modèles les plus avancés de ses concurrents. Opus, le modèle le plus grand, semble éclipser à la fois GPT-4 et Gemini Ultra dans des tests rigoureux, offrant une combinaison remarquable d'intelligence et de vitesse. Sonnet, le modèle intermédiaire, excelle dans les tâches nécessitant des réponses rapides, comme la recherche de connaissances ou l'automatisation des ventes. Enfin, Haiku, le plus petit modèle, démontre des performances impressionnantes en termes de performances, de vitesse et de coût, s'imposant dans sa catégorie.

Claude 3 dépasse les attentes

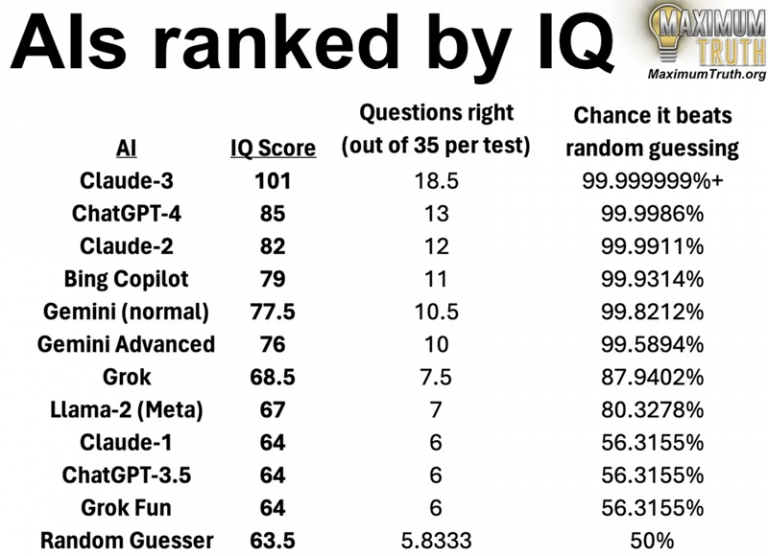

Une étude intrigante vient bouleverser le paysage de l'intelligence artificielle en attribuant un quotient intellectuel (QI) à différents modèles, dont Claude 3. Selon les résultats, Claude 3 surpasse GPT-4 et Gemini sur un test de QI basé sur Norway Mensa, obtenant un score de 104 contre 85 et 77 respectivement. Ces résultats suscitent des débats au sein de la communauté, remettant en question la validité d'évaluer les IA à travers des tests de QI conçus pour mesurer les capacités humaines.

Claude 3 se voit ainsi attribuer une intelligence supérieure à la moyenne américaine, qui est évaluée à un QI de 98. Cependant, certains critiques soulignent que le test en question, basé sur des motifs visuels logiques, peut ne pas être totalement adapté pour évaluer l'intelligence des IA, soulevant des questions sur la pertinence de cette méthode d'évaluation. Les controverses entourant la mesure du QI des modèles d'IA soulèvent des préoccupations quant à la validité et à l'applicabilité de ces tests dans le domaine de l'intelligence artificielle.

Les résultats de ce test de QI, bien que fascinants, font face à des réserves de la part de la communauté des experts en IA. Certains estiment que les tests de QI traditionnels ne sont pas nécessairement adaptés pour évaluer l'intelligence des IA, mettant en évidence des différences fondamentales dans les capacités de traitement de l'information entre les machines et les êtres humains.

La controverse entourant ces évaluations montre bien la nécessité de développer des métriques plus appropriées pour évaluer les performances des modèles d'IA. En effet, une IA n’est pas “intelligente” dans le sens où elle se contente seulement de recracher des informations stockées, de manière logique certe, mais elle n’est pas comparable à l’articulation complexe d’un cerveau humain.