La semaine dernière, des ingénieurs de la division allemande de Microsoft ont expliqué les détails du futur modèle de langage d’OpenAI, la société qui se tchatche derrière ChatGPT. Et selon eux, la sortie de ce modèle est imminente.

OpenAI va bientôt sortir un gros atout de sa manche

En fin d’année dernière, la société américaine OpenAI a complètement redistribué les pions sur l'échiquier de l’intelligence artificielle. Avec le lancement de ChatGPT le grand public a pu découvrir les capacités des modèles de langage que la société couve depuis plusieurs années. Et pourtant, les noms (un peu) barbares que sont GPT-3 et GPT-3.5 ne vous disent sans doute rien alors même qu’ils sont à l’origine du succès fulgurant de ChatGPT.

Mais si nous parlons aujourd’hui de ces modèles qui œuvrent dans l’ombre, c’est tout simplement parce qu’OpenAI s’apprête à lancer GPT-4, un tout nouveau modèle de langage surpuissant. Et c’est par l’intermédiaire de Microsoft et de son directeur de la technologie en Allemagne, Andreas Braun, que nous avons appris que cette évolution était dans les starting-blocks. Et même si l’arrivée de GPT-4 semblait particulièrement proche après l’annonce, début mars, de la sortie de Kosmos-1, rien ne laissait présager une arrivée si rapide de GPT-4.

Que pouvons-nous attendre de GPT-4 ?

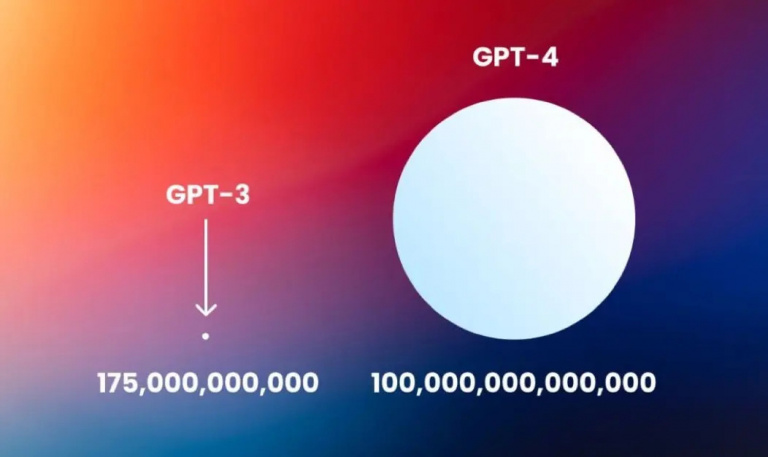

Tout d’abord, l’une des caractéristiques principales de GPT-4 sera sa taille ! Eh oui, si GPT-3 possédait 175 milliards de paramètres, son successeur en possédera, lui, 100 billions - soit presque 600 fois plus ! Inutile donc de vous préciser que ça fait vraiment beaucoup de paramètres. Dans les faits, ce nombre impressionnant permettra aux IA qui embarquent cette technologie (comme ChatGPT) de pouvoir répondre à des situations plus complexes et de générer des réponses encore plus « humaines ».

Crédit Photo : Twitter @HuguesTrjs

Pour autant, et tout aussi fou que cela puisse paraître, le nombre de paramètres n’est pas la caractéristique la plus bluffante de GPT-4 (loin de là). Car oui, si GPT-3 était un pro du format texte, GPT-4 sera capable de générer des réponses dans des formats autres que le texte, comme la vidéo, l’audio ou même l’image, faisant donc de lui un modèle de langage multimodal. Et comme pour ses prédécesseurs, GPT-4 utilisera le deep learning et le traitement du langage naturel pour comprendre les relations et les corrélations entre les différents types de données.

Pour mieux comprendre ce que cela implique, prenons l’exemple de la vidéo. Avec GPT-4, théoriquement, une vidéo et son audio associé peuvent être donnés en entrée afin que le moteur comprenne la conversation et même les émotions de ceux qui y participent. Vous pourrez également reconnaître des objets (ou des personnes) et extraire des informations. Ainsi, on pourrait obtenir un résumé d'un film ou d'une vidéo YouTube comme on obtient maintenant des résumés de réunion par exemple.

Néanmoins, et malgré toutes les informations dont nous disposons, Sam Altman, le PDG d’OpenAI a récemment indiqué que les attentes du public sont peut-être trop grandes et qu’il sera par conséquent déçu lors de la sortie de GPT-4. Mais les dires du big Boss de la société américaine, il y a fort à parier que ce modèle de langage fera tout de même beaucoup parler de lui dans les prochaines semaines.