Si les cartes graphiques servent aux jeux vidéo, ces dernières sont aussi extrêmement utiles pour nourrir les modèles d’intelligences artificielles. Et dans un futur proche, ChatGPT pourrait avoir besoin de beaucoup de GPU NVIDIA…

NVIDIA va se régaler grâce à son pari sur l’IA

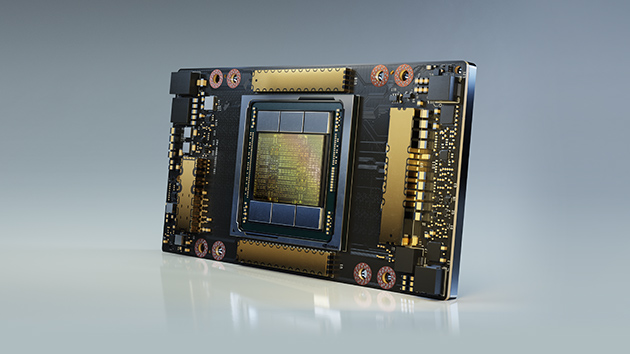

Jensen Huang, le directeur général de NVIDIA, doit se frotter les mains. Le marché des cartes graphiques n’est pas à son apogée certes, mais la société ne produit pas seulement des processeurs graphiques pour les jeux ou la création de contenu - même si c’est grâce à eux que la marque NVIDIA est principalement connue. En fait, la plus grande force de l’entreprise, c’est probablement sa capacité à diversifier son activité commerciale. Et vous savez quoi ? Les chiffres lui donnent raison, surtout lorsque l’on parle de la puce A100 - qui n’a rien à voir avec les GPU que l’on glisse dans notre configuration PC. Spolier : les RTX 3090 ou 4090 ne sont que la partie visible de l’iceberg NVIDIA…

Crédit Photo : Unsplash

Selon le cabinet de conseil AMR (Allied Market Research), en 2031, le marché des puces à destination des applications d’intelligence artificielle (IA) aura un chiffre d’affaires de plus de 263 milliards de dollars. Un montant colossal, surtout si l’on considère qu’en 2021, son chiffre d’affaires s’élevait à un peu plus de 11 milliards de dollars. Et même si ce dernier chiffre est déjà conséquent, il n’est rien à côté de celui des estimations prédites par les experts.

AMD, Intel, Google ou Amazon sont quelques-unes des grandes entreprises qui tentent de rivaliser avec NVIDIA sur le marché des puces alimentées par l’intelligence artificielle. « Elles tentent » seulement, puisque leurs puces sont toutes à des années-lumière de celles de la société de Jensen Huang (NVIDIA détient environ 80% des parts de marché grâce à sa puce A100). Cette domination (presque) totale est directement liée à l’anticipation avec laquelle NVIDIA a su prévoir que le marché des puces d’intelligence artificielle ne tarderait pas à exploser.

30 000 puces graphiques pour alimenter ChatGPT ?

Dans tous les cas, les prévisions des experts prédisent quelque chose que les utilisateurs peuvent facilement deviner si nous observons vers quelle direction se tournent beaucoup de géants de la Tech. Et si les Google, Amazon et compagnie font partie de ces gros poissons, en réalité, il y a beaucoup plus d’organisations qui cimentent leur structure d’affaires spécifiquement sur l’intelligence artificielle. OpenAI, la société qui se cache derrière ChatGPT et d’autres outils dopés à l’IA, fait, d’ailleurs, partie de ce groupe d’organisations.

Crédit Photo : NVIDIA

Tout récemment, le cabinet d’analyse TrendForce a publié un rapport très intéressant dans lequel il affirme qu’OpenAI devra soutenir le futur moteur d’intelligence artificielle de ChatGPT avec plus de 30 000 puces alimentées par l’IA. Ce calcul a été effectué en tenant compte du fait que l’organisation dirigée par Sam Altman a utilisé environ 20 000 de ces puces à partir de 2020 pour constituer le processus de formation de son logiciel. De plus, le cabinet précise que ces calculs ont été effectués en prenant comme référence la capacité de calcul de la puce A100 de NVIDIA, qui est l’une des puces les plus puissantes et les plus utilisées dans ce domaine d’expertise.

Les experts de TrendForce affirment que NVIDIA sera la société qui bénéficiera le plus du développement de l’intelligence artificielle, parce que cette dernière possède déjà des parts de marché ultra-conséquentes par rapport à la concurrence - alors même que l’IA n’était pas encore un sujet d’actualité. Néanmoins, et pour répondre au titre de cet article, nous ne devrions pas assister à une explosion des prix des GPU RTX (tout de suite) pour la simple et bonne raison que ces cartes graphiques ne possèdent pas la même utilité que les puces d’IA. À titre informatif, une RTX 4090 coûte entre 1500 et 2000€ alors qu’une puce A100 coûte près de 9500€. Cette conclusion fait d’ailleurs écho aux déclarations de John Hennessy, le patron d’Alphabet (société mère de Google), qui expliquait que les échanges sollicitant l’intelligence artificielle coûteraient environ dix fois plus cher que les recherches classiques (Reuters).