Dépassant parfois les 100 Go, les dernières productions AAA remplissent le stockage de nos PC et consoles à vitesse grand V. Qu’est ce qui explique cette flambée du gigaoctet ? Pour trouver les bonnes réponses, nous avons posé la question à plusieurs développeurs.

En novembre 2011, l’immense monde ouvert de The Elder Scrolls V : Skyrim , entièrement fait à la main par Bethesda, occupe un peu plus de 10 Go sur les disques durs des PC et consoles de l’époque. Un chiffre déjà très élevé, mais sans comparaison avec aujourd’hui. En 2020, la tendance est à l’explosion : l’open world d’Assassin's Creed Unity dépasse les 60 Go, Gears 5 occupe jusqu’à 81 Go, Borderlands 3 dépasse les 91 Go… Il y a même certains titres qui réclament plus de 100 Go sur PC. Final Fantasy XV , Red Dead Redemption II , c’est à vous que l’on pense. Mais le champion en titre n’est pas un open world : Call of Duty : Modern Warfare , avec toutes ses mises à jour et le mode battle-royale Warzone, prend plus de 190 Go d’espace disque. À l’heure où les SSD sur PC dépassent rarement les 1 To et font en moyenne 512 Go, constater qu’un seul jeu occupe plus de la moitié de son espace de stockage a quelque chose de surréaliste. Mais que s’est-il passé pour que, en l’espace d’une poignée d’années, la taille des productions AAA ait autant augmenté ? Pour répondre à cette question, nous sommes allés directement taper à la porte des développeurs.

Ci dessous : Red Dead Redemption 2, Borderlands 3, Call of Duty : Modern Warfare. Trois jeux qui prennent entre 90 et 190 Go d'espace disque.

Des textures de plus en plus lourdes

Il y a une multitude de facteurs qui expliquent l’augmentation massive de la taille des jeux, mais les deux raisons principales sont, finalement, plutôt évidentes : d’un côté, l’augmentation de la résolution, qui nécessite des textures de plus en plus lourdes. De l’autre, la disparition progressive du support physique au profit du 100% dématérialisé, qui fait sauter le verrou de la limitation lié à la taille du disque. “Avec l’arrivée des PS4 Pro et Xbox One X, le support des résolutions 1440p (2160x1440 pixels) et 4K (3840x2160 pixels) se sont démocratisés dans les jeux.”, nous explique Jérôme Banal, directeur technique chez Dontnod (Life is Strange , Vampyr ). ”Cela implique d’augmenter la taille des textures pour garder un niveau de détail suffisant à l’écran. Or, une texture en 4096x4096 prend 4 fois plus de place qu’une texture en 2048x2048. Et comme la majorité des textures ont des niveaux de détails (mipmap), cette résolution en 4096 vient s’ajouter aux autres mipmaps, donc l’augmentation de la taille est multipliée par quatre. Il en est de même pour les lightmaps, qui représentent une partie très importante du poids des environnements, et bien sûr, qui ont besoin d’une certaine précision pour les ombres précalculées. C’est donc exponentiel.”

Certains moteurs de jeu nous poussent à faire des choix pour trouver le bon équilibre entre temps de chargement et gestion des assets.

Plus on monte en définition, plus les textures nécessaires à l’affichage d’un environnement en 3D sont lourdes, donc. Et, dans bien des cas, les développeurs font le choix d’augmenter la taille d’un jeu pour l’optimiser davantage et notamment accélérer les temps de chargement, comme nous l’explique Eric Audinet, directeur technique du studio Amplitude (Endless Space , Humankind ) : “Certains moteurs de jeu nous poussent à faire des choix pour trouver le bon équilibre entre temps de chargement et gestion des assets (ressources numériques qui composent un jeu, comme une texture, un fichier son, etc.). Par exemple, un même asset se retrouve dans deux niveaux distincts et est copié/collé/sauvegardé dans chacun des fichiers des niveaux, plutôt que d’avoir été référencé et partagé dans un autre fichier d’assets communs. Ce genre de pratique rend la gestion des assets plus simple et peut permettre d’accélérer les temps de chargement. C’est une balance entre espace disque versus temps de chargement, et comme l’espace disque est « disponible », alors on privilégie souvent les temps de chargement.”

Très impressionnant, l'Unreal Engine 5 devrait augmenter la taille des jeux

Les équipes techniques font donc souvent le choix de dupliquer le même asset, dans le but de maximiser les performances du jeu. Un choix finalement logique, qui privilégie l’expérience du joueur une fois le titre lancé. Yannick Vautier, fondateur de Sentry Games, actuellement en train de préparer Cellyon : Boss Confrontation , nous donne d’ailleurs un exemple concret : “Imaginons qu'on voit un élément de décor de très loin. Comme il est tout petit, il n'y a pas besoin de charger la texture HD, au contraire ça prendrait de la puissance pour rien. Il faut une texture plus petite, et ça, en théorie le jeu pourrait la calculer, mais là encore, ça demande de la puissance à la machine du joueur. On précalcule donc toutes les tailles différentes en amont et on les stocke dans le jeu. Si on peut gagner quelques images par seconde au détriment d'un jeu un peu plus lourd, il n'y a pas d'hésitation à avoir.”

Compresser oui, mais pas n’importe comment

Les jeux sont donc de plus en plus gros à cause de la montée en résolution et la disparition du support physique, mais également pour un simple souci d’optimisation. Pour autant, nos espaces de stockage restent limités, en attendant un jour très hypothétique où le cloud et le “local” ne feront plus qu’un, et les développeurs se doivent malgré tout de faire quelques efforts. Lors de la dernière mise à jour de Call of Duty : Modern Warfare, Infinity Ward, conscient que son FPS a atteint une taille problématique, a fourni un quelques efforts pour limiter le volume de la saison 4. À coup de mises à jour de 40, 50 ou 60 Go, les précédentes versions du titre demandaient parfois plusieurs heures de téléchargement. Pour la saison 4, le téléchargement est certes long, mais, au final, l’ensemble de la mise à jour ne pèse que 4 Go. Une prouesse rendue possible par la compression des données, actuellement le moyen le plus efficace de limiter la taille des productions AAA, comme nous l’explique Jérôme Banal :

“Pour limiter la taille des données, la première chose est d’assurer un suivi dans le temps de la taille des données. Cela permet de détecter rapidement tout problème, que cela soit simplement une mauvaise configuration de données ou un type de données qui prend plus de place que prévu ou non nécessaire. Ensuite, compression à tous les étages : par exemple, compresser les textures et lightmaps en DXT (format natif des cartes graphiques), compresser l’audio en Vorbis ou en Opus etc. Nos données spécifiques, comme nos animations faciales, ont leur propre procédé de stockage pour prendre le minimum de place. Certains développeurs vont plus loin encore ! Par exemple, Id Software compressait ses textures en JPEG, pour les reconvertir en DXT au chargement. Enfin, une compression finale similaire à celle utilisée pour les fichiers Zip est en général appliquée sur les fichiers.”

La décompression de certains formats pendant le jeu peut aussi avoir un coût prohibitif ou introduire une latence indésirable.

Mais la compression n’est pas une solution miracle et peut détériorer la qualité d’un asset, tout en nécessitant de la puissance de calcul supplémentaire : “Bien sûr, la majorité de ces compressions ne sont pas sans perte, donc il y a un choix à faire entre qualité des données et taille des données”, ajoute le directeur technique de Dontnod. “Les équipes travaillent dur pour produire leur art donc nous ne voulons pas les détériorer ou les dénaturer outre mesure. La décompression de certains formats pendant le jeu peut aussi avoir un coût prohibitif ou introduire une latence indésirable.”

Chez Amplitude, d’ailleurs, la compression de données n’est d’ailleurs pas privilégiée : “En général, on évite de trop compresser les données, car leur décompression peut prendre trop de temps, surtout depuis que l’utilisation des SSD se généralise et que les vitesses de lecture sont très rapides.” , ajoute Eric Audinet.

La PlayStation 5 et la Xbox Series X vont-elles changer la donne ?

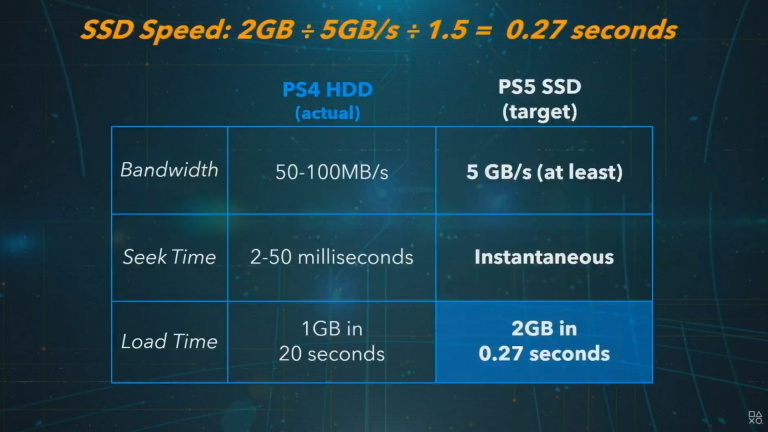

Le SSD joue d’ailleurs un rôle très important dans l’affaire, étant à la fois une contrainte et un avantage. D’un côté, le grand public est rarement équipé en SSD de grande capacité, ce qui limite nécessairement le nombre de jeux qu’il peut installer. De l’autre, la vitesse de lecture et d’écriture de ces disques reste une aubaine pour les développeurs, qui peuvent alors charger plus rapidement une plus grande quantité d’assets. Un aspect technique primordial qui, jusqu’à présent, était réservé au PC. Mais cela va changer avec l’arrivée de la PlayStation 5 et de la Xbox Series X, toutes deux équipées de SSD très rapides. Pour autant, il ne faut pas se leurrer, la prochaine génération de console de salon s’accompagnera très certainement d’une augmentation de la taille des jeux. C’est en tout ce que pense Jérôme Banal :

“Avec les nouvelles consoles, nous allons certainement assister encore à une certaine augmentation de la taille des jeux. Objets plus détaillés (la dernière technologie d’Epic, Nanite, est assez parlante sur le sujet), vidéos pré-rendues en 4K, textures 4K voire 8K (par exemple pour les gros plans sur le visage )… Les SSD sont plus rapides et vont donc permettre de transférer plus rapidement les données en mémoire, et permettre ainsi d’en charger plus depuis le disque, sans impact sur la performance.“

Mais le SSD de la PS5 et de la Xbox Series X pourraient permettre une compression et décompression des données plus efficaces : “Toutefois, cela pourrait être contrebalancé par le fait que ces consoles incluent une décompression matérielle, qui obtient parfois de très bons taux de compression. Cela pourrait contenir cette progression… sur consoles. Sur PC, la décompression doit se faire sur le processeur, donc les algorithmes rapides et peu efficaces resteront sans doute privilégiés pour ne pas s’aliéner le marché des PC “non gamers”, afin de continuer à être disponibles pour le plus grand nombre.”, ajoute Jérôme Banal.

Selon Eric Audinet d’Amplitude, “un SSD ultra rapide permet seulement de charger plus vite, plus de contenu : "Soit un développeur en profite pour charger davantage de contenu, à des résolutions « classiques » Full HD, soit il en profite pour charger, dans un même temps, du contenu à des résolutions plus élevées (4K et plus)”. Un avis partagé par Yannick Vautier de Sentry Games : “il y a toutes les chances que les jeux AAA continuent de s'élargir, car ils seront capables d'afficher des éléments de plus en plus en haute définition de façon fluide, grâce aux avancées en termes de hardware et de moteur de jeu, par exemple avec l’Unreal Engine 5."

Soyez donc prévenus : les jeux de 2021 seront encore plus gros, car plus beaux et plus détaillés. À ce rythme, on se demande d’ailleurs si les 1 To de stockage des prochaines consoles seront suffisants. Côté connexion à Internet, il ne faut pas non plus oublier que tout le monde n’est pas doté de la fibre et qu’un téléchargement de 80 ou 100 Go peut être particulièrement long et frustrant. Sur ce point, laissons le mot de la fin à Romain de Waubert, directeur créatif et co-fondateur d’Amplitude : « Pour synthétiser, je dirais que le passage de la distribution physique (et leurs limites de tailles inhérentes) à la distribution digitale, a fait sauter le verrou de la taille. Aujourd’hui se pose-t-on réellement la question de la taille de nos jeux ? Non. Mais cela pourrait revenir, car dans certains pays la bande passante n’est pas illimitée et le Go peut coûter assez cher selon les opérateurs. Je ne serai pas étonné que soit les utilisateurs, soit les distributeurs, face à l’explosion des Go, viennent à leur tour nous demander de mieux contrôler la taille de nos jeux. »