Lors de la conférence de Mark Cerny, l'architecte principal de la PlayStation 5 , l’un des sujets abordés en profondeur fût celui des capacités sonores de la future console de Sony. On fait donc le point sur tout ce qui a été dit pour comprendre et imaginer ce à quoi on pourra réellement s’attendre du côté des oreilles.

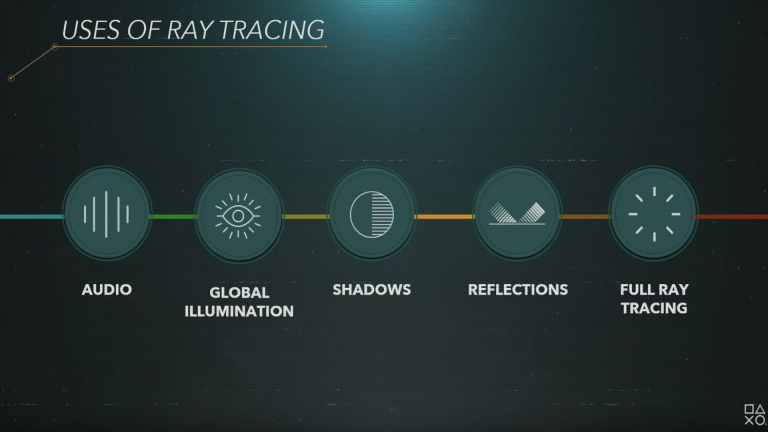

Le ray tracing audio sera bien de la partie

On s’y attendait un peu vu la présence d’un GPU optimisé pour le ray tracing, mais Sony a bien aligné son discours sur celui de Microsoft en confirmant par le biais d’un visuel la possibilité pour les développeurs d’utiliser les capacités de calculs graphiques pour influer de manière dynamique sur le mixage audio. Pour rappel, le ray tracing audio, ou path tracing, est une technique de calcul du trajet parcouru par un “rayon” sonore entre sa source et l’auditeur, impliquant des possibles réverbérations ou absorptions de fréquences par différentes surfaces ou objets, de manière dynamique. Une technique relativement gourmande en calculs pour qui voudrait l’utiliser pleinement. Néanmoins, Mark Cerny s’est montré rassurant sur cette fonction optionnelle pour les développeurs qui n’en auraient pas besoin ou qui voudraient simplement s’en servir comme une petite touche supplémentaire.

Je crois qu’il ne faudra pas plus d'un million de calculs de rayon par seconde pour obtenir un vrai impact sur le son. Ca devrait être suffisant pour des calculs d'occlusion et de réverbération.

La gestion des sources dans un espace 3D

En plus du ray tracing audio, Mark Cerny est revenu sur l’histoire de Playstation, et notamment des différences entre PS3 et PS4 en termes de gestion des sources sonores. Architecte de la PS4, il a pourtant pointé la difficulté de cette machine à traiter correctement les différents flux audio et a loué le couple CELL - SPU (Sound Processing Unit) de la PS3, parfaitement adapté à ce type de calculs qu’il estime devoir être effectué près de 200 fois par seconde, soit une fréquence supérieure aux calculs relatifs à l’image.

Toujours selon Mark Cerny, la plus belle avancée en la matière sur la génération précédente fut celle apportée par le PS VR, le casque étant équipé de sa propre unité de gestion du son et ses propres algorithmes, avec une capacité de près de 50 sources sonores 3D simultanées. Quant à la PS5, si elle devait utiliser ce type d’algorithme, elle serait en théorie capable de gérer jusqu’à 1000 sources sonores de ce type, avec jusqu’à 100 pistes audio différentes. Un nombre qui semble peu utile et qui devrait se réduire avec la complexification des algorithmes utilisés. Néanmoins, on peut facilement imaginer que la nouvelle machine sera, par exemple, capable de simuler les gouttes de pluie qui tombent dans un espace 3D, là où ses prédécesseurs auraient simplement utilisé un fichier son global.

La nouveautés avec ce genre de calculs, c’est évidemment l’augmentation de l’immersion, l’impression de présence au sein du jeu. Le but étant de rendre l’environnement sonore cohérent par rapport au visuel, au point que le cerveau s’abandonne plus facilement à cette réalité alternative. Et puisque nous parlons de jeu, l’autre point d’amélioration qui en découle, c’est la spatialisation des sources sonores, la capacité pour le joueur de localiser avec précision la provenance des différents bruits, avec l’impact que l’on imagine pour un jeu de tir, d’infiltration ou même un titre plus narratif. Un spatialisation qui existe déjà au niveau horizontal, et que l’on aimerait voir se développer en trois dimensions.

HRTF is the new Surround

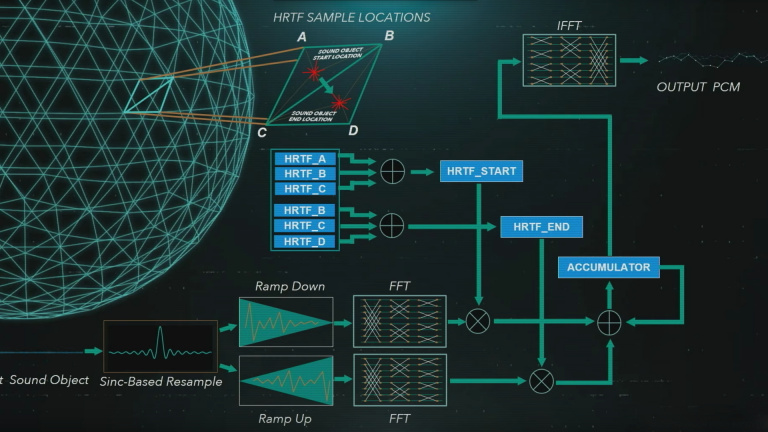

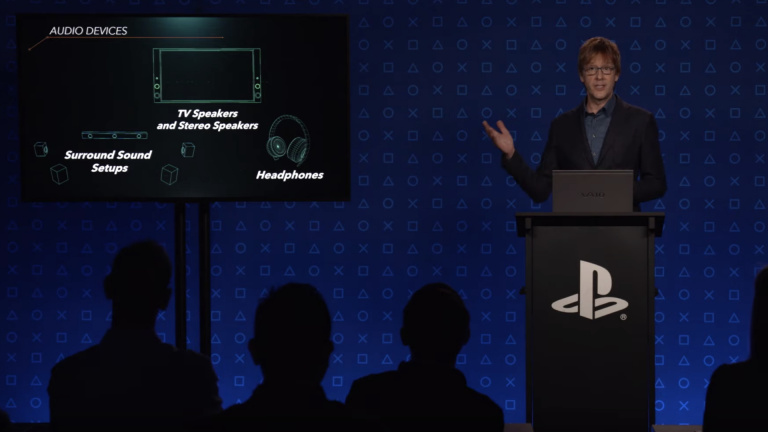

Néanmoins, ce genre de promesse se heurte à une difficulté que Mark Cerny a parfaitement identifiée et pour laquelle le développeur apporte quelques éclairages : l’HRTF. Derrière cet acronyme pour Head-Related Transfer Function, se cache la prise en compte de la tête, des oreilles et des lobes du joueur pour le calcul des différentes variations d’égalisation et de déphasage. Ce principe, dont nous vous parlions déjà dans notre article sur les différentes technologies de surround , offre un énorme avantage pour l’immersion sonore mais demande des calculs faramineux que la PS5 gèrera grâce à un combo hardware/software dédié : le Tempest Engine. Basé sur la technologie des GPU d’AMD, mais avec une architecture proche du SPU de la PS3, cet ensemble permettra de réaliser des calculs très typés, comparables à ce que propose le Dolby Atmos, mais avec l’avantage de fonctionner sans licence, pour n’importe quel jeu et sur n’importe quel périphérique de diffusion : enceintes de télé, barre de son, casque, etc …

Et si on imagine mal se faire scanner le crâne et l’oreille pour savoir quel est notre propre profil HRTF, Marc Cerny assure que les développeurs pourront proposer 5 profils type différents dès la sortie de la machine, histoire de toucher un large public, avec la possibilité d’affiner dans le futur pour que tous les joueurs puissent profiter de cette technologie.

Une conférence qui ne dit pas tout

Evidemment, cette conférence dédiée aux développeurs laisse un vide pour les joueurs que nous sommes. Ainsi nous regretterons de ne pas avoir d’information sur les formats audio gérés par la console, leur débit, leur niveau de précision, de même que la connectique que proposera la PS5. De même, il nous manque les détails concernant la gestion du son en sans fil : bluetooth, format propriétaire, multi-room, son géré via la manette, ainsi que la compatibilité avec nos anciens périphériques, micros et casques. Toutes ces questions restent en suspens pour le moment et il nous faudra certainement attendre une présentation plus “grand public” pour avoir les réponses.