L’un des ingénieurs de Microsoft a dévoilé, lors d’un podcast animé par le Major Nelson, que la prochaine console du géant américain proposerait une amélioration de la spatialisation sonore s’appuyant sur la technologie du Ray Tracing. Une information qui nous mène à nous poser des questions sur la technique, les possibilités et les véritables enjeux d’une telle technologie.

Le Ray Tracing Audio, comme certains l’appellent déjà, représente peut être le futur de ce que sera, à terme, le traitement sonore dans les jeux vidéo. Si on se réfère à ce qu’est le Ray Tracing pour la lumière (et pour ceux qui ne savent pas, allez faire un tour du côté de l’article de Jiikaa qui explique ça parfaitement ), sa version acoustique proposerait donc de suivre le chemin de l’onde sonore, d’en calculer les réflexions, les absorptions totales ou partielles, jusqu’à ce qu’elle arrive finalement à nos oreilles virtuelles, en stéréo comme en 7.1. Sur le papier, tout ça semble très logique, et nous nous étonnerions presque que cette techno ne soit pas déjà à l’oeuvre depuis longtemps. Mais dans la réalité, c’est un peu plus compliqué.

L’ère du bricolage

En effet, ce sont aujourd’hui d’autres principes qui sont majoritairement utilisés. Des techniques plus simples, basées avant tout sur le mixage des sources sonores avec application d’effets. En clair, on prend différents sons sous forme de samples ou de synthèses, et on ajuste plusieurs paramètres manuellement, ou de manière semi-automatisée. On peut ainsi simuler la distance d’un son en faisant varier son volume, ajouter un peu de réverbération et de delay pour modéliser la présence de surfaces réfléchissantes, jouer avec l’égalisation pour illustrer l’absorption des objets qui nous séparent de la source de ce son. Et tout ceci ressemble fort à du bricolage. Il n’y a en tout cas aucune onde virtuelle ni “rayon” sonore calculé en temps réel, mais seulement du bon sens, de l’expérience de la part des ingénieurs du son derrière leur clavier et quelques outils permettant de faire les bons choix.

Il faut dire que cette démarche a pour elle plusieurs avantages. Déjà, on peut la plupart du temps appliquer les effets en avance afin qu’ils soient intégrés de base dans l’échantillon sonore. Par exemple une voix qui parle dans une cave peut se voir affublée d’une réverbération et d’un délai dès le fichier d’origine, de telle sorte que l’on n’ait pas à appliquer ces effets en temps réel ou que l’on ait au pire que quelques ajustements à faire une fois sur le terrain de jeu. De quoi faire de belles économies de ressources. Ensuite, il faut avouer que le système est simple à mettre en place pour n’importe quel jeu. Un PNJ marche sur la moquette, on sort le fichier “marchesurlamoquette.wave”, on lui applique un volume proportionnel à la distance et on obtient l’impression d’entendre des pas s’approcher ou s’éloigner sur cette surface.

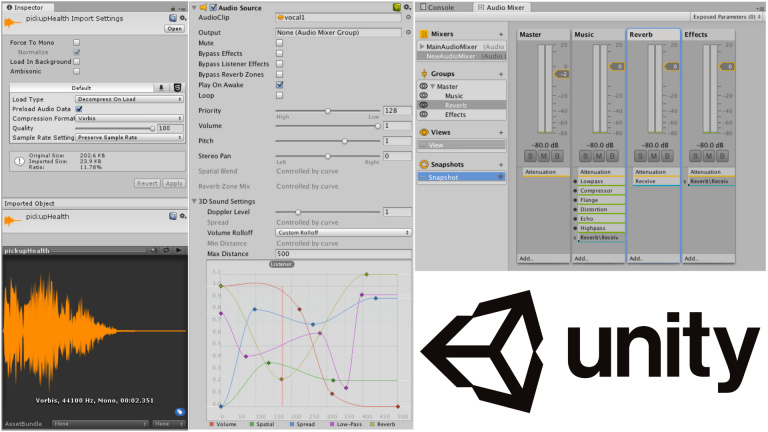

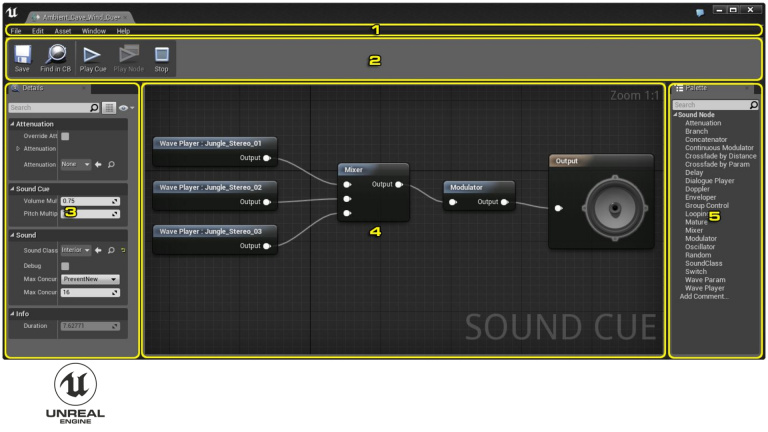

Cette méthode est celle que l’on trouve dans la plupart des moteurs de création de jeux tels qu’Unity ou Unreal, et elle s’applique parfaitement aux environnements 2D ou 3D, avec une gestion de nombreux effets intégrés comme en modules à ajouter à la base du logiciel. On y trouve aussi de véritables gestionnaires de l’espace sonore capables de simuler correctement l’impact d’une zone ouverte ou fermée sur notre audition. C’est par exemple ce que proposent des spécialistes tels que Dolby ou nxWaves, issus l’un du cinéma et l’autre du studio, qui tentent en général de faire ressentir l’espace sonore en trois dimensions sur des appareils de reproduction qui ne proposent que de la stéréo. On s’imagine sur les lieux du jeu alors qu’on n’a finalement qu’un casque sur la tête. Sauf qu’il n’y a là aucun calcul du transport de l’onde sonore tel que le suggère le Ray Tracing Audio.

L’ère du Path Tracing

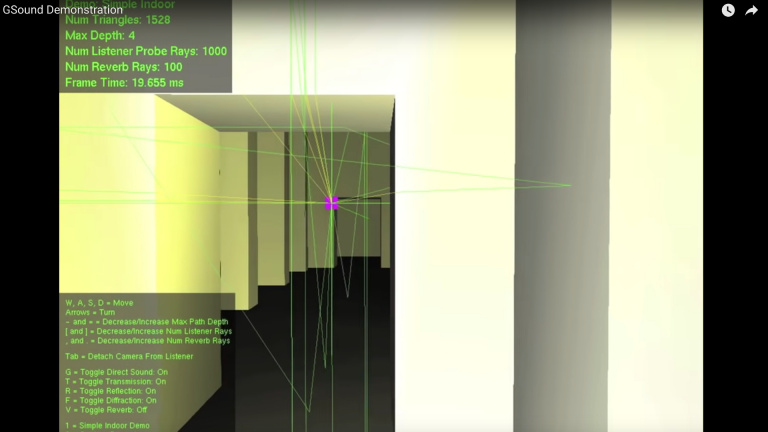

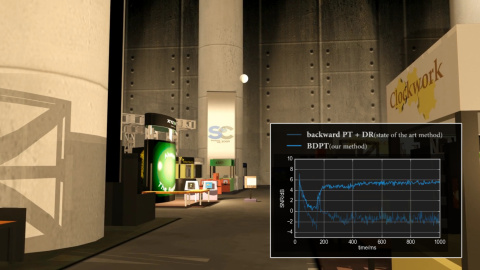

La promesse d’un calcul en temps réel de l’onde virtuelle n’est pas nouvelle, loin de là. On trouve, dès 2011, une publication de l’université Chapel Hill en Caroline du Nord qui fait état d’algorithmes permettant d’agir sur le signal d’une source, en fonction de la position de la source et de l’environnement qui la sépare de l’auditeur. Le résultat permet de modifier les paramètres de réverbération et d’égalisation après avoir utilisé seulement une fraction du temps de calcul de la carte graphique. Donc, ce que propose le “ GSOUND: INTERACTIVE SOUND PROPAGATION FOR GAMES ”, ou Path Tracing, c’est de puiser dans les ressources et les calculs graphiques pour obtenir des données géométriques utilisables dans le cadre de la propagation sonore. Voilà qui rappelle fortement la récente proposition de NVIDIA.

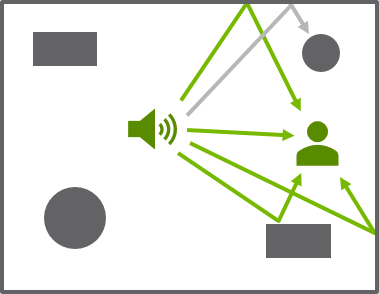

En effet, dès 2017, le plugin VRWorks Audio pour Unreal et Unity permet d’utiliser le hardware et la technologie du Ray Tracing dans le cadre sonore. Des jeux majeurs tels que Call of Duty : Modern Warfare en ont d’ailleurs déjà profité pour améliorer le rendu et la directivité des coups de feux des différentes armes. Dans ce cas précisément, chaque tir déclenche trois “rayons” sonores, dans trois directions différentes, avec pour chaque rayon la prise en compte de sa réverbération et de son absorption. Le décalage des trois sons au moment où l’auditeur les perçoit peut donc être calculé avec exactitude, générant automatiquement un délai et une réverbération qui correspondent bien à l’espace virtuel. L’égalisation sonore des trois signaux peut aussi correspondre avec précision à celle qu’on attendrait dans la réalité, dans le cas d’un son réfléchi sur une surface ou absorbé par une matière. Et ce même si on reste dans une approximation très simplifiée de ce que ferait une véritable onde, avec toute sa complexité.

Le rendu global, pour peu que l’algorithme derrière tout ça soit bien utilisé, ne peut qu’en être meilleur, surtout qu’avec la puissance en augmentation allouée à ces fonctions, on peut améliorer encore et encore la précision du rendu, prendre plus de sources en compte, plus de rayons par source. Le but est d’atteindre une certaine forme de réalisme, à la manière du photo-réalisme que l’on obtient en visuel. Pour l’auditeur, c’est la promesse d’une amélioration de son intégration dans l’espace en trois dimensions avec des renseignements supplémentaires au niveau de l’audio et une immersion plus naturelle.

Notre avenir est-il pour bientôt ?

Nous pouvons donc imaginer un futur, plus ou moins proche, dans lequel l’ensemble des sons émis par l’environnement et les personnages d’un jeu profiteront de cette technologie, améliorant du coup notre perception de ces éléments. Sauf qu’il y a aujourd’hui de nombreuses limitations qui nous semblent encore infranchissables, et ce malgré l’arrivée d’une nouvelle génération de consoles. Parlons d’abord de la charge de calcul. Le Ray Tracing est extrêmement gourmand et nécessite des calculs bien spécifiques, plutôt adaptés à un hardware dédié. Les PlayStation 5 et Xbox Series X ont promis la présence d’un tel hardware même s’il est clair qu’il servira avant tout à la gestion des éclairages, le son étant, d’un point de vue du public comme des développeurs, secondaire par rapport à l’image.

Ensuite, on peut bien évidemment se poser la question de l’intérêt d’une telle amélioration du son si celle-ci ne concerne qu’une petite partie de l’environnement. Les tirs de Call Of Duty sont certes importants, mais le sont-ils moins que les pas des adversaires comme des coéquipiers, leurs voix, les sons ambiants. Or ces éléments sont encore aujourd’hui manipulés de façon classique, sans Ray Tracing Audio. Et la raison est toujours la même : la charge de calcul que cela nécessiterait pour un impact plutôt limité sur le joueur. Ce dernier préférant, et c’est compréhensible, voir son image améliorée en priorité.

D’ailleurs, si le public a autant de mal à se passionner pour la qualité du rendu sonore, c’est surtout parce que ses améliorations sont perçues comme subjectives. On a énormément de difficulté à comparer deux rendus proches mais différents, leur qualité, l’immersion qu’il procurent. On peut bien sortir des courbes, montrer des chiffres, le public a démontré à plusieurs reprises qu’il préférait le pratique au qualitatif. N’en déplaise aux défenseurs du vinyle ou de la haute définition, victimes de la vindicte populaire, la majorité n’accorde que très peu d’intérêt aux performances audio. Alors leur abandonner une bonne part de la puissance de leur machine, ça semble perdu d’avance.

Reste la possibilité d’une position intermédiaire : utiliser l’expérience du Ray Tracing Audio pour en faire une version allégée. Obtenir du calcul des rayons les distances, les matériaux rencontrés, et utiliser ces données pour faire varier des paramètres simples de délai, de réverbération et d’égalisation. Une version améliorée par le Ray Tracing des techniques classiques. C’est probablement cette solution qui sera majoritairement choisie dans la plupart des titres qui voudront afficher leur compatibilité avec la fonction, sans trop y sacrifier de puissance.

Et c’est bien là le nerf de la guerre qui se prépare entre Xbox Series X et PlayStation 5, toutes deux très certainement capables de prouesses au niveau sonore : obtenir les résultats les plus convaincants avec le moins de puissance possible, surtout en ce qui concerne le son. Car il y a tout de même peu de chances que l’on entende autant parler de qualité sonore et de gestion audio, que de résolution et de rafraîchissement d’image. Et avec la dose de calculs qu’elle nécessite, la technologie du ray tracing audio, tout aussi prometteuse qu’elle soit, nous semble encore loin de devenir la nouvelle norme.